近年、ChatGPTのような大規模言語モデル(LLM)をクラウドではなくローカルPCで動かすニーズが高まっています。

理由は主に以下の3つです。

オフライン利用(ネット接続なしで動く)

データの安全性(社内情報や機密情報を外部に送らない)

ランニングコスト削減(API課金不要)

この記事では、Windows環境でLM Studioを使って「gpt-oss-20b」を動かす方法を、初心者でも分かるように解説します。

gpt-oss-20bとLM Studioとは

gpt-ossとは?

gpt-ossは、OpenAIが公開したオープンソースのGPTモデルシリーズです。

商用利用可能で、ローカル環境での実行やカスタマイズがしやすいのが特徴です。

| モデル名 | 特徴 | 推奨環境 |

|---|---|---|

| gpt-oss-20b | 約200億パラメータ。高速かつ比較的軽量。文章生成や要約、質問応答に十分な性能。 | GPU 16GB VRAM 以上(RTX 3090 / 4090 など)または高性能CPU |

| gpt-oss-120b | 約1,200億パラメータ。高精度・高性能。o4-miniに近い品質。 | GPU 80GB VRAM級(例:NVIDIA A100 80GB) |

ポイント

- 個人PCで動かすなら 20bモデルが現実的

- 120bは研究用やデータセンター向け

LM Studioとは?

LM Studioは、ローカルPC上でLLMを動かすためのGUIアプリケーションです。

特徴は以下の通りです。

- Hugging Faceや自分のモデルを簡単に読み込める

- OpenAI互換APIサーバとして動作可能

- Windows / Mac / Linux対応

- 量子化モデル(軽量化版)をGUIでダウンロードして即実行

初心者でもクリック操作だけでモデルのダウンロード→実行→チャットが可能です。

インストールと準備

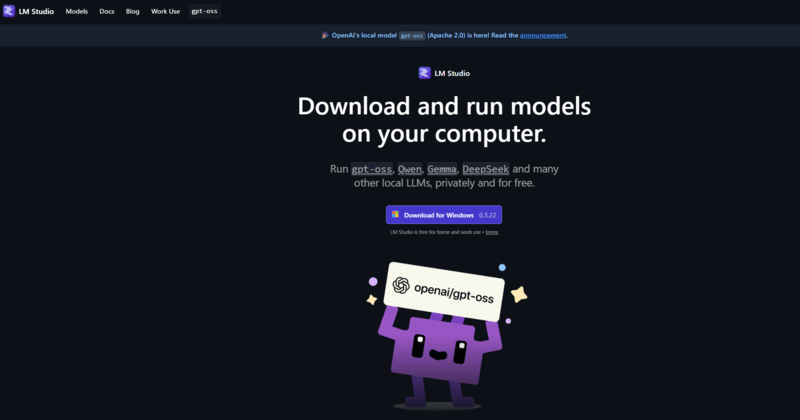

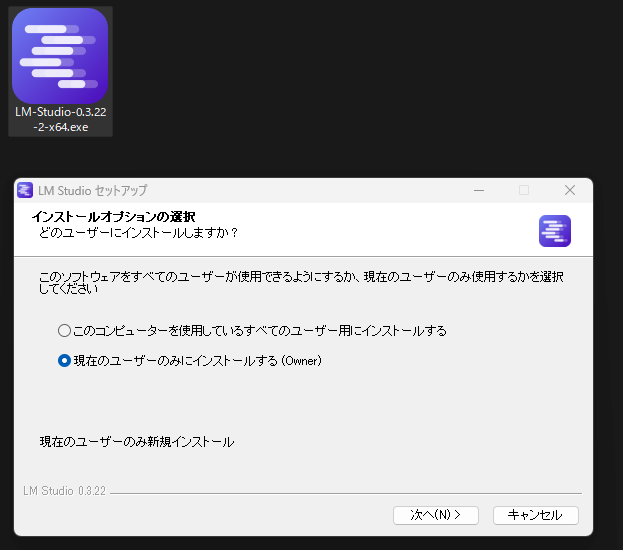

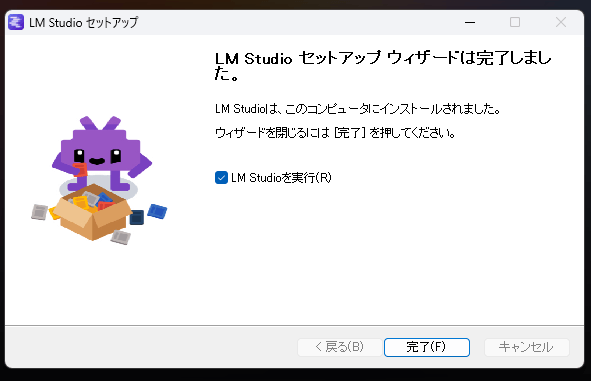

5-1. LM Studioを入手

- LM Studio公式サイト(https://lmstudio.ai/)からWindows版インストーラをダウンロード

- インストーラ(LM-Studio-0.3.22-2-x64.exe)を実行し、画面の指示に従ってインストール

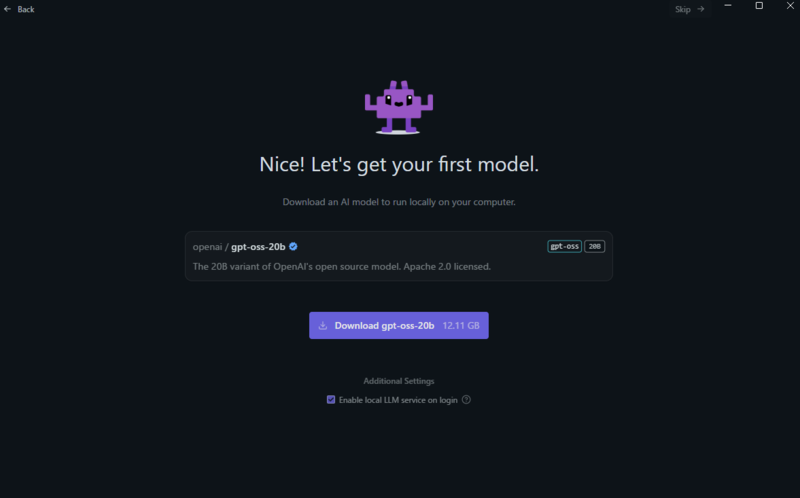

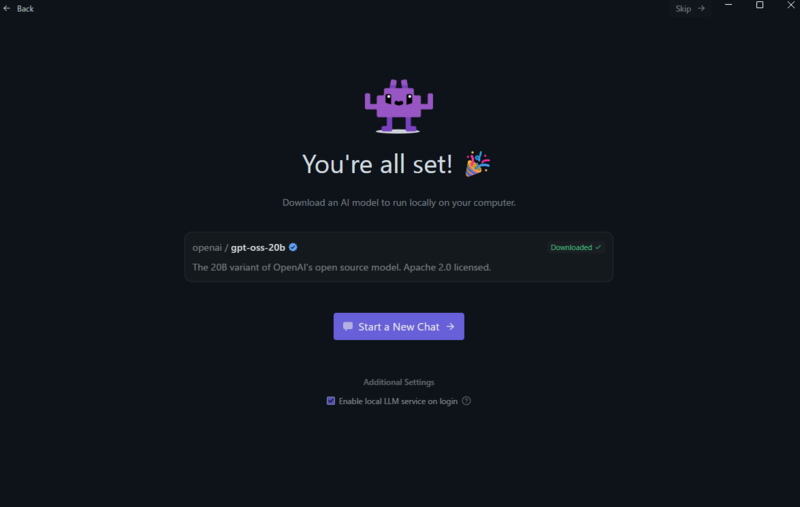

モデルをダウンロード

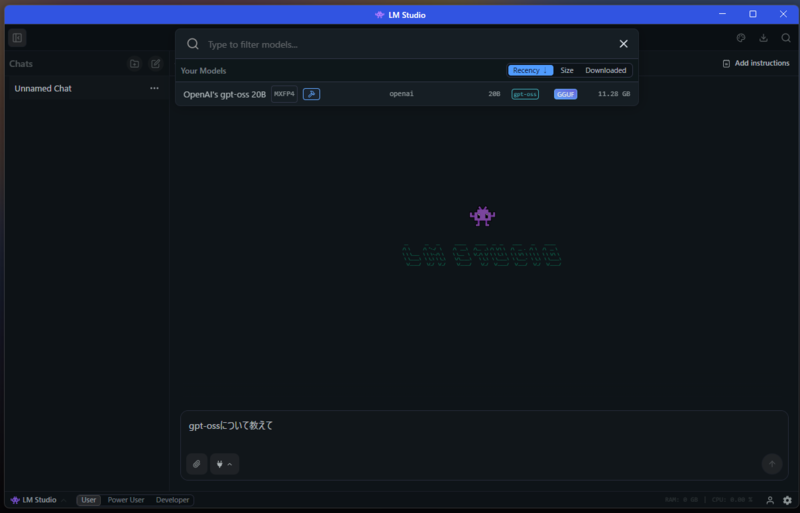

LM Studioを起動しgpt-oss-20bモデルをダウンロードする。

gpt-oss-20bモデルを選択

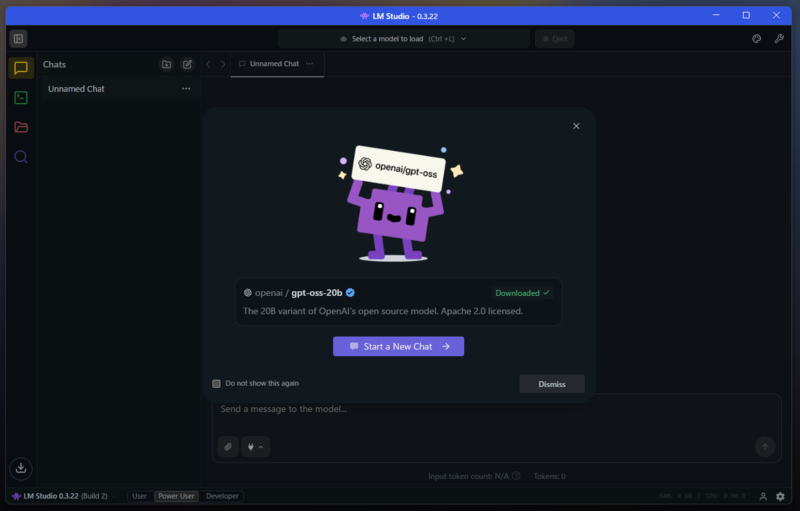

「Select a model to load」から

gpt-oss-20b を選択

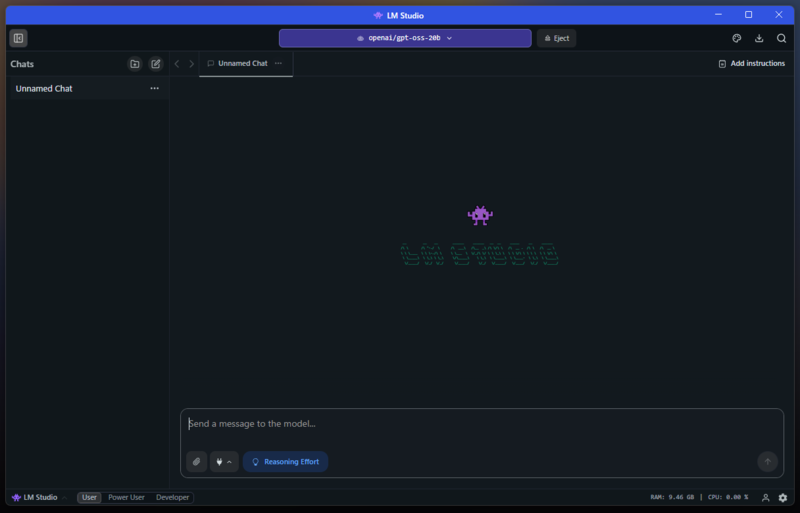

チャットの開始

参考:Docker Desktop MCP ToolkitでDuckDuckGo MCPサーバーをgpt-oss 20bに導入

まとめ

- gpt-oss-20bは個人PCで動かせる高性能LLM

- gpt-oss-120bはより高精度だが超大規模GPUが必要

- LM Studioを使えばGUIで簡単にモデルを管理・実行可能

- Windows環境なら、LM Studio+量子化gpt-oss-20bで快適にローカルLLMが使える

参考

GPU利用:NVIDIA GPU搭載なら設定でGPU推論をONにすると高速化

日本語表示:App Settings → General → Languageで日本語を選択する。

Ollamaについて: